AI历史中的7个试验

使我们走到今天的进步、惊喜和失败。

有资格参加的公司将得到一份持续一年的SOC 2类型报告。这可以帮助你完成更多的交易,达到你的收入目标,并开始奠定安全最佳实践的基础。如果你只有几分钟的时间来观看,以下是投资者、运营商和创始人应该了解的人工智能的历史。

世界的规则。AI最惨烈的失败可能是一个名为 "Cyc "的项目。1984年,道格拉斯-莱纳特开始尝试创建一个对我们的世界有所了解的程序。这位斯坦福大学教授当时试图通过输入数以百万计的规则和断言来发展这种环境,人工智能可以用来推理--包括像 "所有植物都是树 "这样的基本知识。莱纳特认为,知识储备不足是人工智能的一个巨大障碍,最好通过完整的人工干预来解决。尽管经过数十年的发展和数以亿计的投资,Cyc一直在努力提供有意义的结果。

体现的人工智能。在20世纪80年代,出现了一个新的实践派,挑战人工智能的信条。由澳大利亚学者Rodney Brooks领导的这一派认为,真正的智能不会来自精心设计的逻辑框架,而是通过让机器接受感官输入并从环境中学习。这种 "具身 "的人工智能方法带来了很实用的机器人,尽管应用范围很窄。

模仿大脑。Geoff Hinton他经常被称为现代人工智能的 "教父"。这位多伦多大学的教授通过他坚定的信念赢得了这一荣誉,即强大的智能将通过对大脑的模式进行模仿来实现。辛顿对 "神经网络 "的贡献--一种直接基于我们灰质的结构--为现代人工智能系统的发展铺平了道路。

在实践中学习。你如何创造一个能够击败世界上最伟大的围棋选手的人工智能?在2010年代中期,剑桥大学的创业公司DeepMind展示了一种被称为 "强化学习 "的全新学习技术的潜力。DeepMind的引擎不是通过一套严格的规则来学习如何下棋或围棋,而是通过玩游戏和接受对其行为的积极或消极反馈来使其发展。这种方法已经推动了远远超出围棋棋盘的进步。

在他们的经典作品《历史的教训》中,丈夫Will和妻子Ariel Durant分析了人类文明的故事。在他们精辟而深刻的观点中,有这样一段沉思: "当下是为了行动而合起的过去,而过去是为了理解而展开的现在"。

当下,没有任何一个方面能像人工智能那样准备好了从根本上改变我们的生活结构。这项技术正在以难以置信的速度加速发展。一年前,众人预测人工智能将在2045年到来;今天,大家又认为认为是2031年。在不到十年的时间里,我们可能会发现我们正在与一个几乎在各方面都优于我们的智能进行竞争和合作。尽管行业中的一些人认为这是在吓唬人,但这也难怪一大片学术界人士呼吁在整个行业内 "暂停 "开发最强大的人工智能模型。

为了解我们是如何走到这一步的,以及人工智能在未来几年可能会带我们发展到哪里,我们需要先铺开我们的现在,来看看过去。在今天的文章中,我们将试图通过七个实验来了解人工智能的历史。在这样做的过程中,我们将讨论创新和失败、错误的开始和突破,这些都定义了这种创造智能付出的无形但又疯狂的努力。

在我们开始之前,有几条注意事项值得一提。首先,我们对 "实验 "一词的使用比较宽泛。就我们的目的而言,一篇学术论文、新颖的程序或呼呼作响的机器人都符合这个定义。第二,这段历史假设了之前几乎没有人工智能的知识。因此,这位其中技术解释是简略的,而不是精雕细琢过的,这里没有复杂方程式。第三,也是最重要的一点,这是一部有限的编年史,是经过设计的。所有的历史都经过提炼的,这部作品尤其如此。天才和野心的伟大时刻存在于我们的选择之外。

最后一点:这篇文章是关于现代人工智能的基础和现状的迷你系列的第一篇,我们将在未来几周和几个月内不断增加补充。我们计划涵盖该领域的起源和技术,并探索这个行业最强大的公司和高管人员。如果你认为也有别人会喜欢这个旅程,请与他们分享这篇文章。

实验1:逻辑理论家(1955)

在离康涅狄格河岸一英里的地方,教会牧师Eleazar Wheelock 于1769年创建了Dartmouth。这是一所位于新罕布什尔州汉诺威镇的庄严但规模不大的大学。"先生,正如我所说,这是一所小规模的大学,但也有一些人热爱它,"据说著名的第19届演说家和参议员Daniel Webster曾这样评价他的母校。

在这个学校在一块被乐观地命名为 "平原 "的“不平整“土地上定居近两百年后,它接待了一些学者,这些学者从事的一项任务可能会被Wheelock认为是亵渎神明的。(谁敢与神明争锋,造出如此复杂的机器?)1956年,John McCarthy --当时的数学助理教授--召开了一个为期12周的 "人工智能 "研讨会。其目的无非是想知道如何创造智能机器。

McCarthy的期望很高:"将尝试寻找如何让机器自行使用语言,形成抽象和概念,解决现在留给人类的各种问题,"他在资助申请中写道。“我们认为,如果经过精心挑选的一组科学家在一个夏天的时间里共同研究这些问题,就可以在其中一个或多个问题上取得重大进展。“这个独特的小组包括Claude Shannon、Marvin Minsky、 Nat Rochester和Ray Solomonoff等名人。

对于一个经常被它存在的分歧和差异所定义的领域来说,即使是会议的名字也会引起争议,这是很正常的。在McCarthy会议之前的几年里,学者们使用了一系列术语来描述这个新兴领域,包括 "控制论"、"自动机 "和 "思维机器"。McCarthy选择他的名字是因为它的中立性;这个名字也一直被用到现在。

虽然这个夏天可能没有达到麦卡锡的崇高期望,但它对这个领域的贡献不仅仅是命名。RAND智囊团的雇员McCarthy和Herbert Simon公布了一项创新,在随后的几年里获得了传奇性的地位。有趣的是,当时的参会者基本上忽视了它--这既是因为Newell 和 Simon所谓的傲慢,也是因为他们倾向于关注他们的创新所带来的心理影响,而不是其技术重要性。

就在几个月前,1955年冬天,Newell 和 Simon还有与 Simon公司的同事Cliff Shaw一起--设计了一个能够证明复杂数学定理的程序。"逻辑理论家 "被设计为像许多人以为的人类思维那样工作:遵循规则和演绎逻辑。在这方面,逻辑理论家代表了人工智能“符号”学派的第一个例子,其定义是坚持结构存在的合理性。

Logic Theorist 通过探索“搜索树”来运作——本质上是可能结果的分支框架,使用启发式的方法来寻找最有希望的路线。这种方法成功地证明了Bertrand Russell和Alfred North Whitehead的《数学原理》一章中概述的52条定理中的38条。当逻辑理论家的发明者与Russell分享他们程序的能力,特别是指出它是如何改进他的一个定理的时候,据说他当时 "高兴地回应"。

尽管那个夏天在Hanover被忽略了,但《逻辑理论家》已被公认为第一个功能性人工智能程序和符号性人工智能的先驱范例。这一学派将在接下来的三十年里主宰这个领域。

实验2:SHRDLU和Blocks World(1968)。

2008年,CNNMoney询问了一些全球领导人,从Michael Bloomberg到General Petraeus,询问他们曾经得到的最好的建议。当时当任谷歌总裁的Larry Page提到了他在斯坦福大学的博士课程。他向教授展示了他有兴趣研究的 "大约十个“不同主题,其中包括探索网络链接结构的想法。据称,教授指着这个题目说:"嗯,这个题目似乎是一个非常好的想法。" 这种赞美在后续被证明是一种及其委婉说法;Page的研究将为谷歌帝国的搜索引擎奠定基础。

这位顾问是斯坦福大学教授、人工智能先驱Terry Winograd。早在Winograd向Page推荐一个价值万亿美元的想法之前,他就创造了一个被称为 "SHRDLU "的革命性程序。虽然它看起来像一个威尔士小镇的名字,但SHRDLU是一个眨眼的参考,指的是Linotype机器上的按键顺序--无意义的短语ETAOIN SHRDLU会经常错误地出现在报纸上。

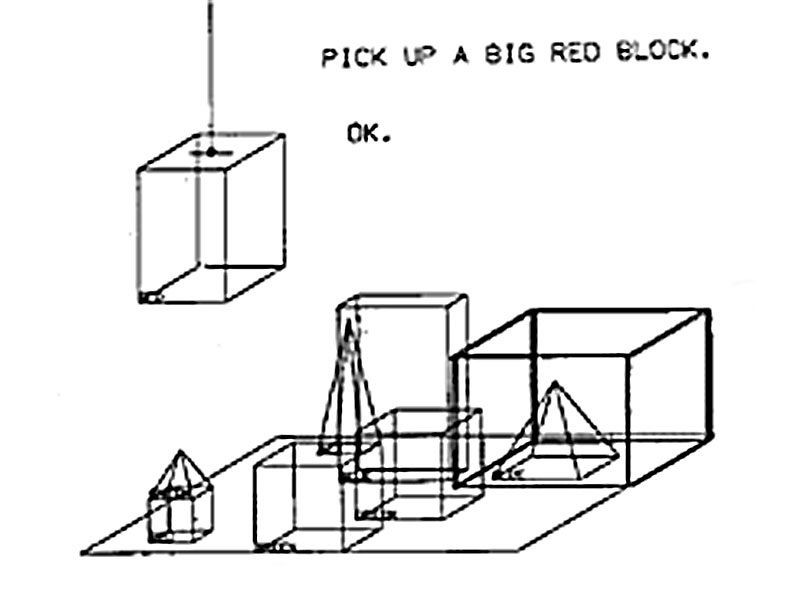

Winograd的程序展示了一个名为 "Blocks World "的模拟:一个由不同颜色的盒子、方块和金字塔组成的封闭环境。通过自然语言查询,用户可以让程序操纵环境,移动各种物体以遵守特定的指令。例如,用户可以告诉SHRDLU "找到一个比你手中的积木更高的积木",或者询问 "金字塔是否可以由一个积木支撑"。

如用户对话所示,SHRDLU理解某些真理:例如,知道两个金字塔不能叠在一起。该程序还记住了它以前的动作,并能学会用特定的名字来指代某些配置。

批评者指出,鉴于SHRDLU对模拟环境的依赖,它缺乏现实世界的实践和明显的限制。然而,最终,SHRDLU被证明是人工智能发展的一个关键部分。虽然这仍然只是象征性方法的一个例子—但其所展示的智能是通过形式化的逻辑推理而非突发行为产生的--Winograd的创作展示了令人印象深刻的新的兼容能力,其自然语言能力尤其值得注意。SHRDLU使用的对话界面今天仍然无处不在。

实验3:Cyc (1984)

Jorge Luis Borges的短篇小说《论科学的精确性》讲述了一个文明的故事,该文明绘制的地图与它所管辖的领土大小相当。"阿根廷文学大师在他的一段故事中写道:"制图师协会绘制了一张帝国地图,其大小就是帝国的大小,并与帝国点对点相吻合。

Cyc就是人工智能版本的 "点对点 "地图,这个项目是如此雄心勃勃,接近于创造一个全新的现实社会。它因其新颖性而受到赞扬,也但被谴责为 "人工智能中最臭名昭著的败例"。

1984年,斯坦福大学教授Douglas Lenat着手解决了他在截至到当时的人工智能程序中看到的一个固有问题:它们缺乏常识。在过去的十年中,"专家系统 "一直占主导地位:依靠人类知识的程序,通过各种离散规则输入,并应用于狭窄的范围。例如,在1972年,斯坦福大学开始研究一个名为MYCIN的程序。通过借鉴500多条规则,MYCIN可以有效地诊断和治疗血液感染,"首次表明了人工智能系统可以在重要问题上胜过人类专家"。

虽然MYCIN及其后继者很实用,而且常常令人印象深刻,但Lenat发现它们只不过是披着智力的 "外衣 "而已。当然,这些程序对血液疾病或法律问题有很多了解,但在规定的范围之外,他们又了解什么呢?

为了超越“只是披着智能外衣“的智能,Lenat认为人工智能系统需要背景。因此,在1984年,在联邦的支持和资助下,他开始建立Cyc。他的计划简单得令人难以置信:为了给他的程序提供必要的知识,Lenat和一个研究小组输入了反映共识现实的规则和论断。这包括从物理学到政治学、生物学到经济学的人类知识跨度的信息。像 "所有的树都是植物 "和 "蝙蝠有翅膀 "这样的口令必须被精心添加到Cyc的知识架构中。截至2016年,已经输入了超过1500万条规则。在Borges的故事中,历代人都意识到一张与领土大小相当的地图的毫不实用。它被丢弃在沙漠中,逐渐褪色,被风吹得破烂不堪。在Lenat开始项目工作近40年后,Cyc还没有证明它所吸收的数亿投资和累积的数千年的人类努力是正确的。尽管Cyc的技术似乎确实被现实世界的利益相关者所使用,但多年来的实验表明它所拥有的知识是零散的,削弱了其效用。同时,较新的架构和比Lenat更渐进的方法带来了更好的结果。

归根结底,Cyc对人工智能发展的最大贡献是它的失败。尽管Lenat的才华和胆识,以及公共和私营部门利益相关者的承诺,它还是未能突围。在这样的情况下,它揭示了 "专家系统 "和基于知识的人工智能的局限性。

实验4:《大象不下棋》(1990年)

智能化的梦想经常与机器人技术交织在一起。仅仅拥有一个抽象的、悬浮在空中的大脑是不够的。为了使智能产生影响,它需要一个实体。

从20世纪80年代中期开始,出现了一派反叛的研究人员,主张 "具身 "的人工智能的重要性。在澳大利亚人Rodney Brooks的领导下,这一派认为过去的逻辑驱动型、符号型人工智能倡导者误解了智能;人类和其他动物并不依靠刻意输入的规则来驾驭生活;他们是通过与环境的互动和学习来实现的。如果人工智能程序要变得有用,它们需要 "置身于现实世界"。

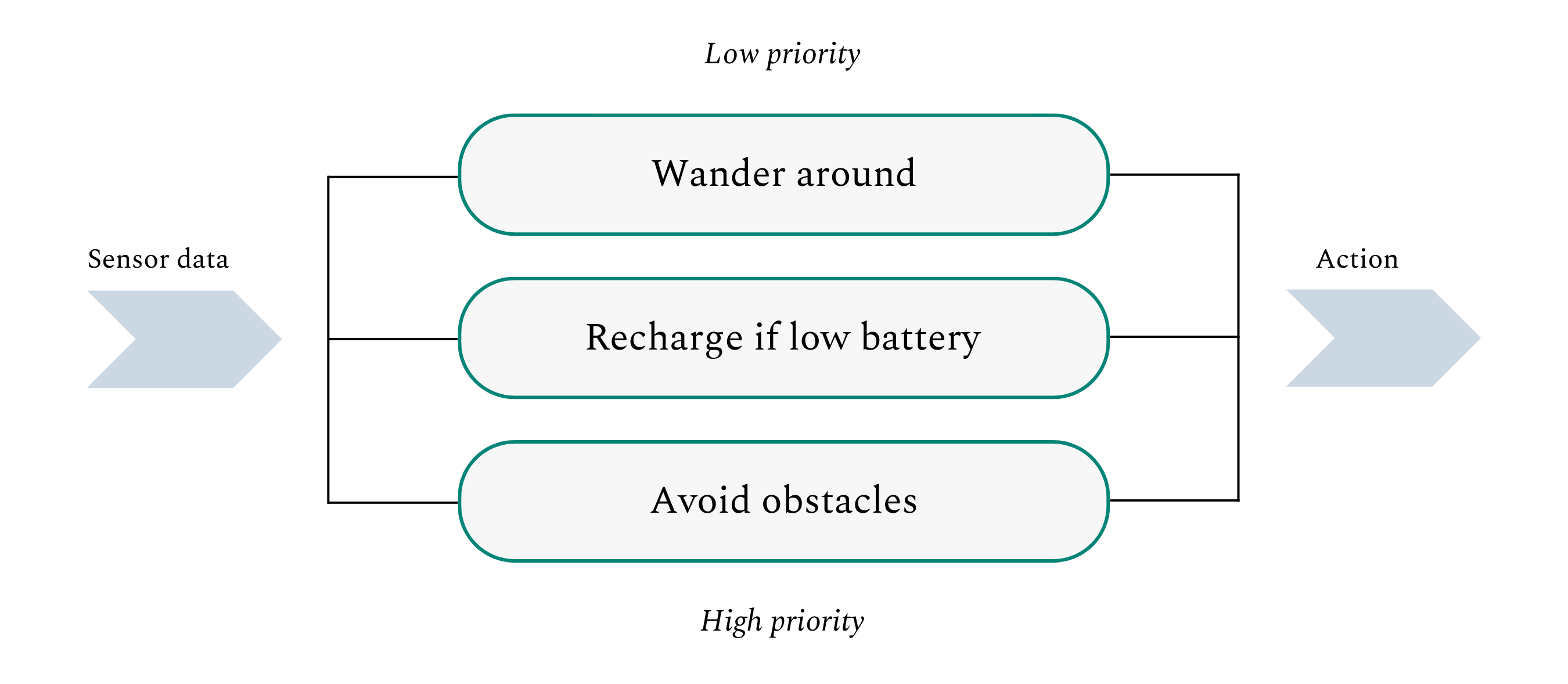

Brooks1990年的论文《大象不下棋》提炼了这个新的 "行为人工智能 "运动的理念,并记录了这位当时麻省理工学院教授的机器人实验。除了概述像 "Allen "和 "Herbert"(对逻辑理论家的创始人很好的nod)这样乱窜的机器人的成就外,Brooks还阐述了人工智能程序的新结构。简单地说,Brooks的 "子归属架构 "将机器人的预期行动分散成离散的行为,如 "避开障碍物 "和 "四处游荡"。然后,它将这些行动编入一个以最基本的要件为基础的架构。例如,一个拥有这种架构的机器人会优先考虑避开障碍物,然后向上移动到更广泛的探索。

Brook认为,行为人工智能将可能有真正的一席之地,这一信念最终得到了证实。在他发表论文的同一年,Brook和麻省理工学院的两位同事成立了iRobot公司。12年后,即2002年,该公司发布了其现在的旗舰产品Roomba。虽然没有人会相信Roomba是一台会思考的机器,但这个大受欢迎的自动吸尘器是Brook体现技术是如何提供实际利益的一个明显例子。

实验5:AlexNet(2012)

1931年,《反对爱因斯坦的百名作家》出版。在这本书中,几十位学者试图戳穿这位德国物理学家的理论。据说,爱因斯坦在回应该书的出版时调侃道:"如果我是错的,那么一个学者就足够了!"

在他职业生涯的大部分时间里,Geoff Hinton被要求对反对者一直蔑视。从20世纪70年代开始,这位英国研究人员开始用技术来理解和模仿大脑的结构。与符号或行为人工智能阵营不同,Hinton是一小批不随大流的研究人员中的一员,他们认为真正的智能不会源于逻辑框架、庞大的规则汇编或环境互动。相反,它将来自于对大脑结构和功能的复制,创造出 "人工神经网络",也就是我们常说的 "神经网"。

简单地说,这些网络的作用就像我们的大脑一样:各种输入导致神经元发射,从而产生某些输出。在传统的神经网络中,神经元或 "单元 "被安排在 "前额 "层中,这意味着前一层的输出被后一层接收。这个网络中的每个单元都执行某种重要的计算活动:就像识别图像的一部分,以便最终能识别其中的内容。

Hinton并不是第一个在这个想法中看到希望的研究者。事实上,在1958年,就在历史性的Dartmouth研讨会的两年后,康奈尔大学的学者Frank Rosenblatt建造了一台 "感知器 "机器--本质上是神经网络的原始版本。可以说,人们对这项技术的兴趣甚至早于Rosenblatt的工作,20世纪40年代的研究人员就已经用电路构建了 "神经元"。

然而,当其他人为该领域做出贡献时,尽管人工智能界的许多人反对,认为这是浪费时间,但Hinton还是将其推向了前进。"Geoff是地球上仅有的几个追求这项技术的人之一,"商业记者 Ashlee Vance在谈到辛顿的神经网络研究时说。"他只要在学术会议上露面,就会被驱逐到密室关起来。他被当作一个真正的贱民。"

尽管待遇不佳,Hinton从未对他的想法的优势失去信心: "对我来说,这显然是正确的方法。大脑是一个大的神经网络,所以必须是这样的东西才可以工作,因为它在我们的大脑中起作用。" 随着资金和注意力被投入到像Cyc这样基于知识的系统中,Hinton进行了开创性的工作,例如他在1986年发表了关于 "反向传播 "的开创性论文,这是一种神经网络的训练算法。

数据不足和有限的计算能力传统上阻碍了神经网络和其他机器学习技术。大约从2005年开始,情况开始发生变化。更快的芯片可以投入使用中,研究人员可以使用更多的数据。这一芯片势头围绕着一个名为 "深度学习 "的修订概念而巩固下来。与传统的神经网络相比,"深度学习 "网络在三个关键方面更加强大:

1. 更多的底层。不同的层用于进行不同类型的处理,其中的复杂性随着接近输出而增加。通过增加更多的层,即可处理更困难的进程。

2. 更多的单元。在20世纪90年代,神经网络包含大约100个单元,这制约了它们的能力。深度学习网络之后单元大了几个数量级,到2016年达到了约100万个单元。

3. 更多的连接。伴随着更多的层和单元,深度学习运动创造了具有更多连接的神经网。同样,这大大增加了他们的能力。

"AlexNet "代表了深度学习的一个转折点,也是对Hinton思想的一次加冕。2012年,Hinton的两个学生Alex Krizhevsky和Ilya Sutskever创造了一个算法,参加了ImageNet挑战赛。由Fei-Fei Li在2009年创立的ImageNet是一个基础数据库,拥有超过1400万张标记的图片。它被用来训练人工智能图像识别模型:这其中理念是,如果你向程序展示足够多的图片并告诉它所代表的内容,它就能学会准确标记新的、未标记的图片。

为了测试图像识别程序的能力,ImageNet举办了一场年度竞赛,不同的团队争相制作最准确的模型。2010年,表现最好的程序有72%的准确率;2011年,它攀升到75%。两者都远远低于人类95%的平均表现。

在准备2012年的比赛中,AlexNet的团队采取了另一种方法,创建了一个由GPU驱动的深度学习网络。这些更强大的处理器使Alex Krizhevsky和Ilya Sutskever能够有效地训练他们使用复杂的多层次网络。虽然这在今天听起来很平常,但AlexNet团队的选择在当时是非传统的。

结果是惊人的。在ImageNet挑战赛上,AlexNet将其竞争对手远远甩在身后,取得了85%的准确率。最重要的是,它比其他所有算法的表现都要好10%以上。在接下来的几年里,受AlexNet启发的程序的能力将突破人类的门槛。

比起它的能力,AlexNet更代表了人工智能的一个转折点。未来将通过构建由GPU驱动并在大量数据上训练的深度网络来实现。

实验6:"用深度强化学习玩雅达利"(2013)

人工智能与游戏有着悠久的历史渊源。1950年,传奇数学家Claude Shannon撰写了一份名为 "为下棋的计算机编程 "的研究报告,其中概述了创造天才国际象棋机器的技术和算法。当然,不到50年后,IBM又推出了深蓝,这是第一个在规定条件下击败世界冠军的人工智能程序。它在1996年2月10日击败了Garry Kasparov--这是第一次--展示了人工智能在高度复杂、理论上的脑力挑战中胜过人类的能力,引起了人们的极大关注。

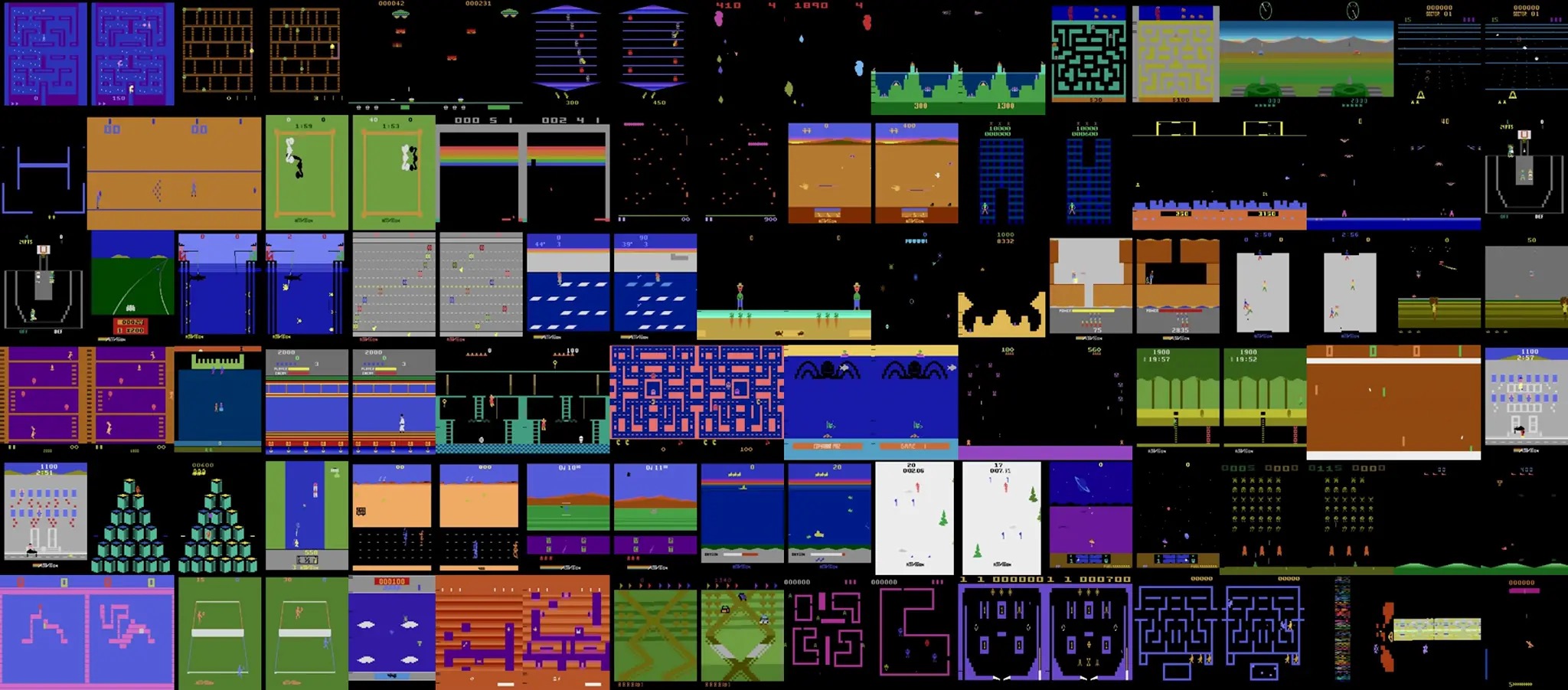

2013年,一种有着新玩法的人工智能面世,尽管它的宣传力度要小得多。那一年,总部位于剑桥的DeepMind公司宣布其目标是创建一个能够玩几十种雅达利视频游戏的 "单一神经网络"。就其本身而言,这可能不是一个特别大胆的任务。让Michael Wooldridge等专家对DeepMind的工作如此感兴趣的是该公司所采用的方法。正如这位牛津大学教授在《人工智能简史》一书中所解释的那样,"没有人告诉程序任何关于它所玩的游戏的事情。" 研究人员并没有试图向其引擎提供某些规则或从冠军球员那里收集的战术。该程序只是在玩游戏,并观察哪些行为会增加它的分数。

这个过程被称为 "强化学习"。强化学习程序不是依靠训练数据,而是通过 "奖励 "来学习。当程序做了一件好事(面向其目标),它就会得到一个积极的奖励。如果它做了一些负面的事情(与目标相反),它就会收到一个负面的奖励。通过这种反复的反馈过程,程序学会了如何达到其目标。因为它没有收到明确的指示,所以它经常通过采用人类可能从未设想过的--也可能不完全理解的--策略而获胜。

DeepMind对于雅达利项目的结果是一个启示。2015年的一篇论文显示,在最初列出的49个雅达利项目中,该引擎已经学会了在29个项目上超越人类。在某些情况下,该程序达到了 "超人 "的水平,并展示了智能、新颖的技术。

尽管其本身令人印象深刻,但DeepMind在雅达利程序方面所做的工作为后来的创新打下了基础。2016年,该公司发布了AlphaGo,这是一个旨在玩中国围棋的人工智能--一个比国际象棋更庞大、更复杂的游戏。以信息论先驱命名的 "香农数",将国际象棋游戏中可能的棋步数定为10123;而围棋的棋步数为10360。DeepMind使用 "监督学习"(将专家棋手的游戏信息反馈给算法)和强化学习的混合方法,创造了一个引擎,依靠人类棋手看起来很战略的技术和战术,以四局一胜的成绩轻松击败了世界冠军李世石。在AlphaGo的成功之后,又出现了AlphaGo Zero和AlphaZero等更广泛、更强大的程序。后者仅用了九个小时就学会了下高水平的国际象棋,只通过自己下棋来学习。

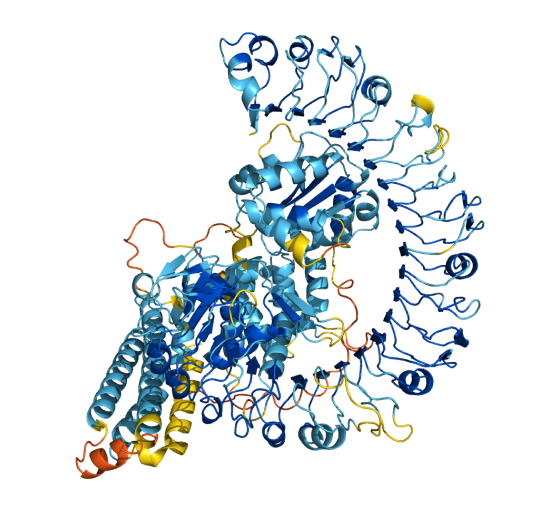

DeepMind的最高成就是AlphaFold。50年来,"蛋白质折叠问题"--弄清蛋白质形成的三维形状--一直是一个未解决的生物 "大挑战"。

通过依靠强化学习和其他技术,AlphaFold从根本上将蛋白质建模的准确性从大约40%提高到85%。正如《人工智能时代》中所述,AlphaFold的影响是深远的,"使世界各地的生物学家和化学家能够重新审视他们一直无法回答的老问题,并提出关于与人类、动物和植物中的病原体作斗争的新问题"。

DeepMind展示了人工智能发展的新方法,其创造了远远超过人类能力的程序,无论是在玩视频游戏还是绘制生物结构图。

实验7:"注意是你所需要的一切"(2017)

不久以前,人工智能在自然语言创造方面相当差。当然,像SHRDLU这样的早期应用展示了一些能力,但总的来说,它的理解和写作的能力比其他技能发展得更慢。到20世纪90年代中期,人工智能可以摧毁像Kasparov这样的传奇大师,但它不可能制作一段描述其成就的文字。即使到了2015年,语言能力也远远落后于深度学习模型在图像识别和游戏玩法方面的非凡能力。

"你所需要的是注意力"标志着一个转折点。2017年的论文介绍了 "转换器",这是一个依赖于一种叫做 "注意 "进程的新颖架构。在最高级别,变压器会同时“关注”其所有输入,并使用它们来预测最佳输出。通过以这种方式关注,变压器可以比以前的模型更好地理解背景和意义。

让我们通过一个基本的例子来说明这一原则。如果你向传统模式提供一个提示,如 "描述一棵palmtree",它可能会搞混。它将搜寻并单独处理每个词,而不会注意到它们之间的联系。你可以想象这可能导致明显的错误。首先,"palm"一词有多种含义:它指的是一种树,也指手的底部。一个没有认识到 "树 "和 "手掌 "相近的人工智能模型可以很轻易地陷入对爱和生命线的狂想,然后再转入对巨大的橡树的讨论。

通过识别和编码内容,转化器能够极大地改善文本预测,为GPT-4和Claude等卓越的对话AI奠定了基础。有趣的是,转化器对大脑的模仿可能比我们最初意识到的要多--再次验证了Hinton的预感。最近的研究表明,对记忆功能至关重要的海马体是一个 "变相的转化器"。这代表着人工智能在寻求体现符合并最终完全超越人类自身的智能的这个方面又向前迈进了一步。

如果你有兴趣进一步探索人工智能的历史,我发现以下书籍很有用,也很有趣: Eric Schmidt、 Henry Kissinger和Daniel Huttenlocher的《人工智能时代》;Daniel Huttenlocher的《人工智能简史》;以及Daniel Huttenlocher的《会思考的机器》。

所有评论